Uso fraudulento de IA en México: delitos digitales sin ley ni regulación

Manipulación, extorsión y censura: los riesgos de la IA sin regulación en México

El uso fraudulento de la inteligencia artificial (IA) ha dejado de ser un asunto de ciencia ficción para convertirse en una realidad alarmante. En México, esta tecnología se ha utilizado con fines fraudulentos, extorsivos, e incluso violentos, sin que exista todavía una regulación eficaz que frene su expansión ni proteja a la ciudadanía. La pregunta es inevitable: ¿estamos verdaderamente protegidos ante el uso fraudulento de la IA?

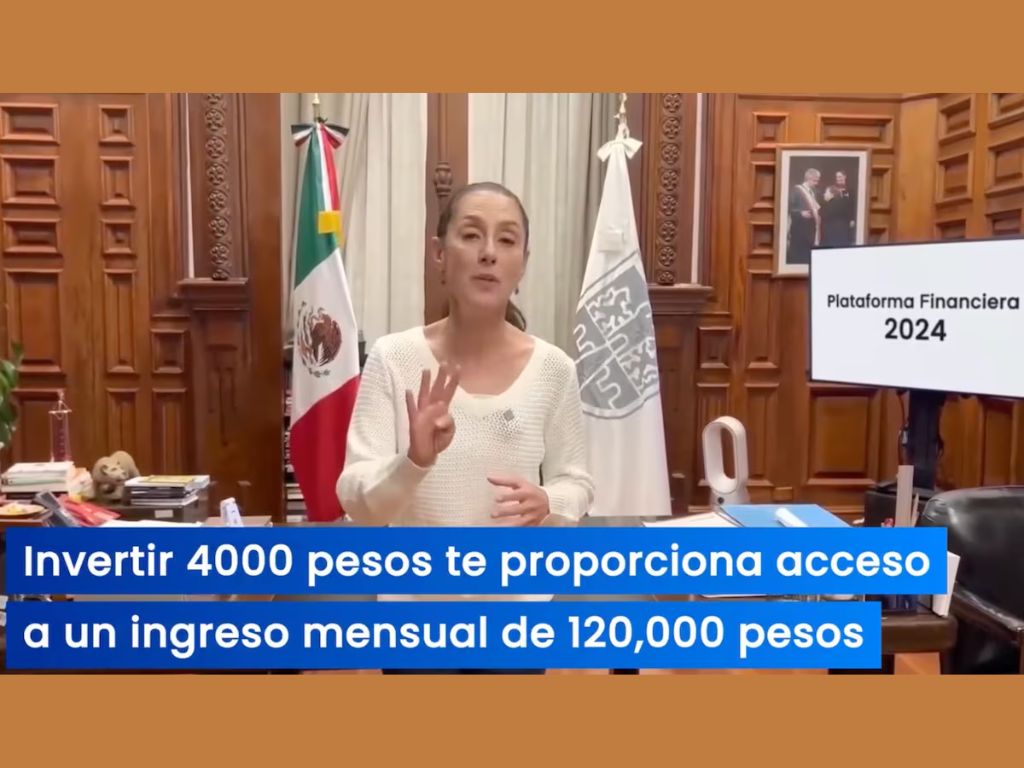

En enero de 2024, la entonces candidata presidencial Claudia Sheinbaum denunció que su imagen y voz habían sido manipuladas mediante IA para difundir mensajes falsos. En un caso documentado, se le hizo “promover” inversiones en Pemex. Alertó a la ciudadanía y medios internacionales dieron cobertura al hecho, como lo hizo El País. Esta manipulación, sin embargo, no es un caso aislado, sino una muestra de una problemática creciente que alcanza múltiples sectores de la vida pública y privada.

Voces robadas: el reclamo de artistas y creadores por el uso fraudulento de la IA

El pasado domingo, un grupo de locutores, actores y productores se manifestó frente al Monumento a la Revolución, en Ciudad de México. Su denuncia es contundente: la IA está clonando voces humanas sin consentimiento ni compensación. Un caso de posible uso indebido surgió en el propio Instituto Nacional Electoral (INE). Los inconformes exigen una regulación legal urgente para frenar la precarización laboral que pudiera provocar el uso no autorizado de esta tecnología.

“La precarización laboral por clonación de voces es solo el inicio. Si no se regula, veremos una crisis de derechos autorales y humanos”, advierte el actor y activista Mario Zaragoza.

La presidenta Sheinbaum respondió ofreciendo respaldo y proponiendo diseñar conjuntamente esquemas de protección. Pero hasta hoy no existe en el país un marco normativo que establezca límites claros sobre la manipulación de identidad y creación de contenido automatizado.

Siete formas en que la IA se usa de manera fraudulenta en México

El panorama es más amplio y preocupante. “La IA está siendo usada para violentar derechos fundamentales sin que exista un marco legal que lo impida”, señala Renata Ávila, abogada especializada en tecnología y derechos humanos. A continuación, se enumeran casos emblemáticos documentados por especialistas y medios confiables:

1. Violencia digital y pornografía sintética

Un exalumno del IPN manipuló fotos de compañeras con IA para generar contenido sexual falso, que luego vendió sin consentimiento. “Ver mi rostro en un video que nunca grabé fue aterrador. No sabía si alguien más lo había visto”, declaró una joven afectada por deepfakes sexuales en entrevista con Animal Político. La senadora Andrea Chávez fue víctima de un caso similar. Aunque la Ley Olimpia abarca la difusión de contenido íntimo sin autorización, es insuficiente para sortear el hecho de que no existe regulación específica para los deepfakes.

2. Extorsión con imágenes falsas

En ciudades fronterizas como Ciudad Juárez, los delincuentes han enviado videos generados por IA que simulan personas desaparecidas pidiendo rescate. Una familia llegó a entregar 13 mil 500 dólares tras recibir este tipo de manipulación emocional.

3. Robo de identidad y estafas

El uso de IA para crear documentos apócrifos ha crecido 1,200%, según la plataforma global de verificación de identidad Sumsub. Se utilizan identidades sintéticas para fraudes bancarios, suplantación en redes sociales y estafas con criptomonedas o inversiones falsas.

4. Propaganda y manipulación política

Aunque no siempre generativa, la IA también ha sido usada para crear ejércitos de bots, silenciar disidencias y amplificar narrativas favorables al poder. Esto distorsiona el debate público y contribuye a la erosión democrática.

5. Censura automatizada

Sistemas de moderación automática en redes sociales eliminan contenidos de activistas, mujeres indígenas y defensores de derechos. La falta de transparencia en sus algoritmos perpetúa sesgos y silenciamientos.

6. Vigilancia masiva

Plataformas como el C5 y la base de datos Titan permiten el reconocimiento facial y la vigilancia de miles de personas. Sin regulación efectiva ni supervisión independiente, el riesgo de abuso institucional es latente.

7. Huella ecológica de la IA

Investigadores de la UNAM han advertido sobre el alto consumo energético de los servidores que ejecutan IA. Su uso indiscriminado para tareas triviales contribuye a una huella de carbono que aún no se discute con seriedad en las políticas públicas.

Entre la simulación regulatoria y la impunidad

Mientras México carece de una legislación federal específica, la Unión Europea avanza con el AI Act, una ley pionera que busca regular el uso de IA según niveles de riesgo. En Estados Unidos, estados como California han propuesto leyes que castigan la utilización de IA para manipular voces e imágenes sin consentimiento. Estos esfuerzos contrastan con la lentitud del marco normativo mexicano.

En algunos estados, como Sinaloa, ya se aprobaron reformas que penalizan el uso de IA para manipular contenido íntimo, con penas de tres a seis años de prisión. Sin embargo, su aplicación es limitada y no existen disposiciones similares a nivel federal ni en la mayoría de las entidades del país.

El riesgo es que las autoridades sigan reaccionando solo cuando las víctimas tienen alta visibilidad pública —como una presidenta o una senadora— mientras miles de personas anónimas quedan a merced de una tecnología fuera de control.

México necesita con urgencia una legislación transversal, robusta y especializada en delitos digitales asociados a la IA, así como políticas públicas que incorporen principios de ética, privacidad y derechos humanos.

¿Qué hacer ante el uso fraudulento de la IA?

La inteligencia artificial no es, por sí misma, ni buena ni mala. Pero en manos equivocadas, y sobre todo en contextos sin regulación, puede convertirse en una herramienta de violencia, manipulación y fraude. Frente al uso fraudulento de la IA, la sociedad puede protegerse emprendiendo y replicando campañas de concientización o mediante el uso de herramientas de verificación de contenido.

Sin embargo, hace falta más para desactivar la amenaza. Un paso imprescindible es acabar con el vacío legal contra el uso indebido de IA. El Estado mexicano no puede continuar en silencio.

Lee: Contra ciberdelincuencia: verificar, desconfiar, no abrir links